Projektmitglieder

- Nelson Brüchmann

- Benjamin Frühling

- Niklas Hartmann

- Andre Jehsert

- Luca Manzek

- Julian Müller

- Keno Ortmann

- Niklas Rahenbrock

- Yannik Schnaubelt

- Nico Schult

- Julias Thünemann

- Sven Wurzbacher

Website Verantwortliche

Technik

In der Projektgruppe werden verschiedene technische Komponenten verwendet. Diese reichen von bekannten Virtualisierungen mit Docker, bishin zu fachspezifischen Simulationstools wie CARLA.

In der Projektgruppe wird gezielt ROS, ADORe und CARLA genutzt.

- ROS steht für Robot Operating System. Es handelt sich dabei um eine Open-Source-Plattform, die speziell für die Entwicklung von Robotersoftware konzipiert ist.

- CARLA ist eine Open-Source-Simulatorplattform für autonome Fahrzeugforschung und -entwicklung.

- ADORe (Autonomous Driving on Real Roads) ist ein Forschungsprojekt des DLR (Deutsches Zentrum für Luft- und Raumfahrt), das sich auf die Entwicklung autonomer Fahrfähigkeiten für Fahrzeuge im realen Straßenverkehr konzentriert.

Für eine Erreichung der erarbeiteten Ziele und Anforderungen ist eine geeignete Architektur notwendig. Durch den Einsatz von ADORe ist es notwendig, die von der Projektgruppe entwickelte Lösung in ein bestehendes System zu integrieren.

ROS – Robot Operating System

ROS ist ein Open-Source-Betriebssystem für Roboter, welches verschiedene Komponenten einfach und effizient miteinander verbindet. ROS basiert auf einer serviceorientierten Architektur, in der verschiedene Prozesse, die als Knoten bezeichnet werden, über Nachrichten miteinander interagieren.

Dies ist besonders wichtig für Roboter, da sie in der Regel aus einer Vielzahl unterschiedlicher Sensoren, Aktoren, Anzeigen und anderen Komponenten bestehen, die effizient zusammenarbeiten müssen. Ein Hauptziel von ROS ist die Wiederverwendbarkeit von Code in Forschung und Entwicklung. Dadurch soll ein Standard definiert werden, damit nicht jeder Sensor einen individuellen Code benötigt. Derzeit gibt es dreizehn verschiedene ROS Distributionen, welche sich auf zwei verschiedene ROS Versionen, ROS1 und ROS2, aufteilen.

In der Projektgruppe wird ROS1 genutzt, da diese Version von ADORe genutzt wird.

CARLA – Simulationstool

CARLA ist ein Open-Source Fahrsimulator mit dem Fokus auf autonomes Fahren, welcher seit 2017 entwickelt wird (aktuelle Version: 0.9.14 – Stand: Okt 2023). Mit CARLA wird eine realistische Plattform zum Testen und Entwickeln im Bereich autonomes Fahren angeboten.

Der Fahrsimulator basiert auf der Unreal Engine 4, welche eine realistische Physiksimulation bietet.

In der Industrie und Forschung hat sich CARLA bereits in vielen Projekten etabliert, was auf den Open-Source-Status der Software und auf die gut dokumentierte Python API zurückzuführen ist.

Diese API ermöglicht eine einfache Kommunikation und Steuerung der Simulation.

Innerhalb der Projektgruppe wird CARLA in der Version 0.9.13 verwendet, da ADORe diese Version voraussetzt.

CARLA stellt acht verschiedenen Karten in 0.9.13 zu Verfügung, welche autobahnähnliche Straßen (amerikanischer Highway), Landstraßen und Stadtverkehr in unterschiedlichen Komplexitäten repräsentieren.

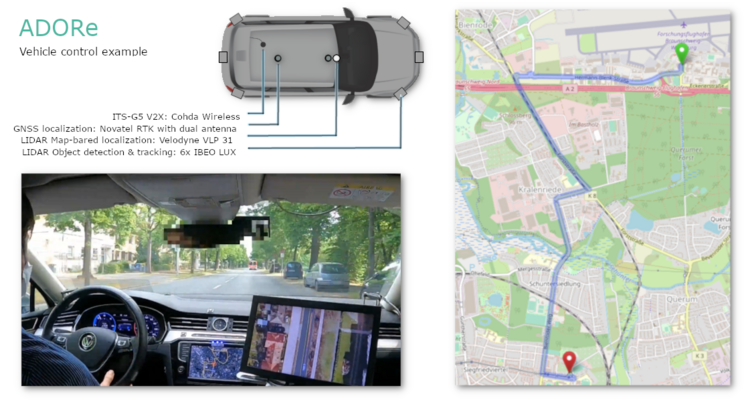

ADORe – Toolkit

ADORe ist ein Softwaretoolkit für die Entscheidungsfindung und der Planung von Trajektorien zur Automation von Fahrzeugen. Konkret plant ADORe Trajektorien und trifft darauf aufbauend im Straßenverkehr Entscheidungen. Diese Entscheidungen werden von ADORe in Form von Steuerungsanweisungen ausgegeben. In einer Demonstration hat das DLR-Institut für Verkehrssystemtechnik ADORe verwendet, um eine Strecke durch das urbane Braunschweig zu fahren. Das Fahrzeug ist mit verschiedenen Sensoren ausgestattet, darunter V2X, GNSS und sieben LiDAR-Sensoren. Mithilfe eines Displays im Fahrzeug kann das Fahrzeug aus einer Vogelperspektive betrachtet werden. Diese Visualisierung basiert auf einer OpenDRIVE Karte. Es stellt sich die Frage, wie die verwendete Sensorik in Verbindung mit dem ADORe-Toolkit genutzt werden kann, um die Realisierung eines automatisierten Fahrzeugs zu ermöglichen.

Denn um ein Fahrzeug, wie in der Demonstration des DLR-Institut für Verkehrssystemtechnik zu automatisieren, wird neben ADORe eine weitere, auf Sensorik basierende SENSE-Komponente benötigt.

Grober Aufbau

Die Softwarelösung wird zwischen mehreren bereits bestehenden Systemen integriert. Aktuell umfasst die Architektur ADORe, adore_if_carla und die CARLA-ROS-Bridge. Die zu entwickelnde Softwarelösung ACDC-Main wird in diese Architektur eingebunden. Das Ziel besteht darin, eine Wahrnehmung gemäß den Anforderungen umzusetzen, um die Perzeption von adore_if_carla zu ADORe zu ersetzen.

Die Abbildung zeigt alle verwendeten Komponenten und deren Kommunikation untereinander. Die gesamte Kommunikation in dem ROS-Block findet mithilfe von ROS-Nachrichten statt. ACDC-Main bezieht Daten aus der CARLA-ROS-Bridge und gibt diese Daten an die Perzeptions-API von ADORe weiter. Ein vollständiger Ersatz von adore_if_carla durch ACDC-Main ist nicht möglich, da auch der Rückweg von ADORe (Fahrzeugsteuerung) über adore_if_carla erfolgt. Daher muss nur der Kommunikationsweg (gekennzeichnet durch das rote Kreuz) zwischen diesen beiden Komponenten entfernt werden.

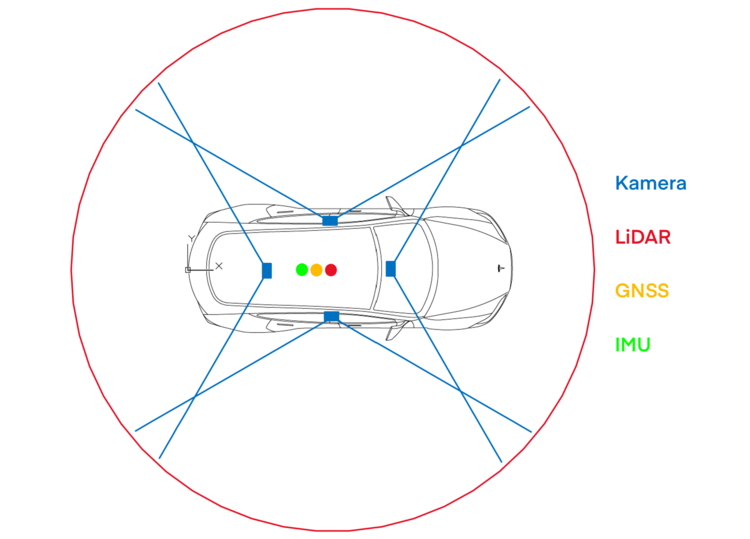

Sensor-Setup des Simulationsfahrzeuges

Die Sensoren und deren Positionen sind von entscheidender Bedeutung, da dies die gesamte Wahrnehmung beeinflusst (und somit auch die Ergebnisse). Um nicht wahllose Positionen und Sensoren zu verwenden, basiert das Sensor-Setup aus der Simulation auf Fahrzeugen aus der Realität. Für die Positionierung und Spezifikationen der zu verwendeten Kameras stützt sich das Setup auf den Model3 von Tesla. Innerhalb des Projektes wurde sich für dieses Modell entschieden, da es auch als Fahrzeug in CARLA verfügbar ist und die Kamerapositionen bekannt sind. Tesla verwendet in der Hardware-Version 4.0 den IMX490-Sensor von Sony 1. Dabei wird jedoch die Anzahl der Kameras auf vier reduziert, um die Komplexität einzuschränken. Diese Entscheidung zieht auch eine Veränderung des FOV mit sich. Abweichend von Telsa wird als FOV aller Kameras 120 Grad festgelegt. Zusätzlich zu den Kameras enthält das Sensor-Setup einen LiDAR-Sensor. Die Position und Spezifikation des Sensors basieren auf dem FAScar. Das FAScar ist ein vom DLR entwickelte Forschungsplattform, welches einen 360 Grad LiDAR-Sensor auf dem Dach des Fahrzeugs verwendet.

An dem Ego-Fahrzeug sind vier Kameras befestigt: eine Frontkamera in der Befestigung des Rückspiegels, jeweils eine Kamera an der linken und rechten B-Säule und eine Kamera mittig auf der Heckscheibe. Die Positionen der vorderen, linken und rechten Kamera spiegeln exakt die des Tesla Model 3 wieder. Die hintere Kamera ist etwas zur Mitte gerückt, um den toten Winkel zu verringern. Weiterhin hat das Ego-Fahrzeug einen LiDAR Sensor, der mittig auf dem Dach platziert wird. Neben den Kameras und dem LiDAR Sensor verfügt das Auto ebenfalls über einen GNSS und IMU Sensor. Die beiden Sensoren sind mittig im Auto verbaut.

| Sensor | Anzahl | Position | Spezifikation |

|---|---|---|---|

| IMU | 1 | Mittig im Auto | Modell: PixHawk 2.1 |

| GNSS | 1 | Mittig im Auto | Modell: Trimble |

| Kamera | 4 | Frontkamera: Befestigung Rückspiegel | Modell: Sony IMX490 FOV: 120° Auflösung: 2880 x 1860 px Bildwiederholungsrate: 20,8 FPS |

| LiDAR | 1 | Mittig auf dem Dach | Modell: Velodyn Reichweite: 100m |