Glossar

Service Desk - allgemeine Anfragen

Teamleitung

Glossar

Eine noch umfangreichere Informationssammlung zum Thema Forschungsdatenmanagement finden Sie unter: https://forschungsdaten.info/themen/

Archivierung / Langzeitspeicherung

Die Archivierung von Forschungsdaten ist die unveränderbare und langfristige Speicherung von Forschungsdaten. Zur Nachvollziehbarkeit von Forschungsergebnissen und zur Sicherstellung der Guten wissenschaftlichen Praxis müssen Forschungsdaten für mindestens 10 Jahre aufbewahrt werden. Bei einer Aufbewahrung von über 10 Jahren spricht man i. d. R. von Langzeitarchivierung (LZA). Gegenüber der Archivierung für einen begrenzten Zeitraum müssen bei der LZA zusätzliche Anforderungen zur dauerhaften Verfügbarkeit erfüllt werden, wie z. B. die Umsetzung von Erhaltungsstrategien. Ein weit verbreiteter Standard, der für die LZA verwendet wird, ist das Open Archival Information System (OAIS).

Besonders wichtig bei der digitalen Archivierung ist, dass die Daten unveränderbar und in einem geeigneten Format abgespeichert werden, um die Erhaltung der Originaldaten und die Lesbarkeit über den gesamten Zeitraum der Aufbewahrung sicherzustellen. Weitere Aspekte, die beachtet werden müssen, sind die Vergabe von adäquaten Zugriffsrechten, das Einhalten von Löschfristen und die Beschreibung durch Metadaten. Die Metadatenvergabe ist besonders bei der Archivierung in einem öffentlichen Repository wichtig, damit die Daten besser auffindbar und nachnutzbar sind. Aber auch bei der nicht-öffentlichen Archivierung sollte dieser Punkt aus Gründen der Nachvollziehbarkeit nicht vernachlässigt werden. Sofern eine Löschpflicht besteht, was insbesondere in der medizinischen Forschung bzw. bei personenbezogenen Daten der Fall sein kann, sollte für die Einhaltung dieser Löschfrist möglichst eine Archivierungsoption gewählt werden, bei der die automatische Löschung der Daten nach einem angegebenen Zeitraum erfolgt.

Werden Forschungsdaten in einem öffentlichen oder institutionellen Repository publiziert, geht hiermit auch automatisch die Archivierung einher. Sollen oder dürfen die Daten nicht öffentlich zugänglich gemacht werden, kann das Archivierungsangebot der eigenen Institution genutzt werden, wenn ein solches besteht. An der Universität Oldenburg gibt es hierfür derzeit nur die Storage-Dienste, mit denen sich eine Archivierung mangels spezieller Funktionen schwer abbilden lässt. Die Einführung eines dedizierten Archivierungssystems befindet sich in der Analyse/Planung.

Arzneimittelgesetz (AMG)

Für die Forschung ist das Arzneimittelgesetz insbesondere dann relevant, wenn eine Klinische Prüfung nach der Definition in §4 Absatz 23 durchgeführt wird. Vereinfacht ausgedrückt, sind das alle Studien mit Arzneimitteln, die interventionell gestaltet sind, d. h., z. B. eine Randomisierung enthalten oder eine andere Form von Festlegung, die die reine Beobachtung der ärztlichen Praxis oder die Zweckbestimmung des Arzneimittels übersteigt. Bei Fragen dazu berät Sie das KKS und die Medizinische Ethikkommission.

Für den Bereich Datenmanagement sind insbesondere die Anforderungen der guten klinischen Praxis einzuhalten. Die Dienstleistungen der Servicestelle Forschungsdatenmanagement sind technisch und organisatorisch grundsätzlich so ausgelegt, dass diese Anforderungen erfüllt werden können. Falls unsere IT-Services in klinischen Prüfungen eingesetzt werden sollen, ist eine Beratung durch die Servicestelle zur Festlegung der Prozesse und Verantwortlichkeiten obligatorisch.

Audit Trail

Als Audit Trail bezeichnet man in EDC-Systemen die Aufzeichnung bzw. die Anzeige/Ausgabe von Datenänderungen. Dabei wird mindestens der Zeitpunkt, der Nutzer und bei Änderungen/Löschungen der Grund erfasst und gespeichert. Somit sind alle Veränderungen auf der Ebene einzelner Datenpunkte nachvollziehbar (auditierbar).

Der Audit Trail ist ein wichtiger Bestandteil der Qualitätsmanagement-Prozesse und er wird durch den Anhang 11 des EG-GMP-Leitfadens zu computergestützten Systemen für den Bereich der GCP-konformen Datenverarbeitung zum Standard definiert.

Biobank / Biomaterialbank (BMB)

Eine Biobank ist eine Sammlung von Biomaterial, wie z. B. Gewebe- und Flüssigproben, und den zugehörigen Proben- und Probandendaten. Biobanken bestehen zum Zwecke der Forschung, ein genauer Verwendungszweck ist zum Zeitpunkt der Probenentnahme jedoch nicht festgelegt. Die Proben und Daten werden daher i. d. R. für einen langen, in den Einwilligungsdokumenten festgelegten, Zeitraum zweck- und studienungebunden gespeichert.

Das Biomaterial wird in der sogenannten Probenbank gelagert, während die assoziierten Daten in Datenbanken gespeichert werden. Die assoziierten Daten lassen sich nach Datenschutz-Leitfaden der TMF [1] in unterschiedliche Kategorien einteilen:

- Identifizierende Daten: Hierunter fallen personenidentifizierende Daten der Probanden und Probandinnen, wie z. B. der Name und das Geburtsdatum. Sie verbleiben i. d. R. an der Stelle, an der die Probenentnahme stattfindet (Klinik/Studienzentrum), oder werden in einer zentralen Patientenliste gespeichert.

- Organisatorische Daten: Die Daten enthalten Informationen über die Probe, die zur Verwaltung und Einordnung der Probe benötigt werden. Hierzu zählen z. B. die Probenart, Informationen über die Probenentnahme und der Lagerung.

- Analysedaten: Werden Proben an Forschende herausgegeben, können diese ihre Ergebnisse an die Biobank zurückmelden. Diese Analysedaten können wie die Probe selbst ein Rückidentifizierungspotenzial besitzen, was bei der Speicherung der Daten zu beachten ist.

- Medizinische Daten/Forschungsdaten: Dies umfasst soziodemografische Daten und klinische Sachverhalte, z. B. Diagnosen und Befunde, die für die Klassifikation des Probanden oder der Probandin und damit für die Erforschung der Probe unerlässlich sind. Der Umfang dieser Daten, die an den Forscher herausgegeben werden, richtet sich nach der wissenschaftlichen Fragestellung.

Die Daten dieser Kategorien sollten aus Datenschutzgründen in voneinander physikalisch und organisatorisch getrennten Datenbanken in pseudonymisierter Form vorliegen.

Mit BBMRi-ERIC ist eine europäische Biobanken-Forschungsdateninfrastruktur im Aufbau, die den Zugang zu Bioproben erleichtern und den Fortschritt in der biomedizinischen Forschung voranbringen möchte. Deutschland wird in diesem Netzwerk durch den German Biobank Node (GBN) vertreten.

- Pommerening, K.; Drepper, J.; Helbing, K.; Ganslandt, T. (2014): Leitfaden zum Datenschutz in medizinischen Forschungsprojekten – Generische Lösungen der TMF 2.0, Schriftenreihe der TMF Band 11, MWV, Berlin.

Datenmanagementplan (DMP)

Ein Datenmanagementplan beinhaltet alle relevanten Informationen zu einem Projekt und zu den Aufgaben, die im Verlauf eines Lebenszyklus in Bezug auf die Forschungsdaten anfallen. Durch die Verwendung eines Datenmanagementplans wird die ausreichende Beschreibung der einzelnen Datenmanagementschritte gewährleistet. Außerdem macht der Einsatz eines solchen Plans den Umgang mit den Forschungsdaten transparent, nachvollziehbar und im Hinblick auf die Einhaltung der Vorgaben überprüfbar. In einigen Fällen wird die Erstellung eines oder ggfs. mehrerer Datenmanagementpläne bei der Beantragung neuer Projekte von Seiten des Fördergebers entweder bereits im Rahmen der Antragsstellung oder innerhalb der ersten Projektlaufzeit erwartet.

Die Servicestelle Forschungsdatenmanagement stellt eine Muster-Vorlage für die Erstellung eines Datenmanagementplans bereit. Informationen hierzu finden Sie in unserem Service-Bereich.

Für Software, die im Rahmen eines Forschungsprojekt enwickelt wird, gibt es spezielle Softwaremanagementpläne.

Einwilligung

Eine Einwilligung hat je nach Rechtsgebiet eine unterschiedliche Bedeutung. In der medizinischen Forschung sind häufig die strafrechtlich relevante Einwilligung (z. B.: § 203 StGB und § 228 StGB) sowie die datenschutzrechtliche Einwilligung nach DSGVO relevant. In diesem Eintrag soll die datenschutzrechtliche Einwilligung behandelt werden.

In der medizinischen Forschung werden in der Regel personenbezogene Daten der besonderen Kategorie verarbeitet. Diese Kategorie von Daten darf nur in Ausnahmen verarbeitet werden. Der häufigste Legitimationsgrund ist hier die Einwilligung (Art. 9 Abs. 2 lit. a DSGVO). Die datenschutzrechtliche Einwilligung wahrt die informationelle Selbstbestimmung der Einwilligung gebenden Person und ermöglicht zugleich die Verarbeitung personenbezogener Daten.

Zusätzlich muss eine Einwilligung informiert, bestimmt und freiwillig erfolgen (Art. 4 Ziff. 11 DSGVO). Des Weiteren dürfen die Daten nur für in der Einwilligung angegebene Zwecke verarbeitet werden (Art. 5 Abs. 1 lit. b DSGVO). Nähere Informationen und Vorlagen finden Sie auf den Seiten der Stabsstelle für Datenschutz und Informationssicherheitsmanagement.

Einwilligungsmanagement

Artikel 7 der DSGVO definiert einige Bedingungen für den Umgang mit Einwilligungen. Hierzu gehören unter anderem die Nachweispflicht der erteilten Einwilligungen (Art. 7 Abs. 1 DSGVO) und das Recht die Einwilligung zu widerrufen (Art. 7 Abs. 3 DSGVO). Für die Erfüllung dieser Bedingungen bedarf es eines Einwilligungsmanagements. Dies erfolgt bislang oft rein papierbasiert.

Digitales Einwilligungsmanagement bietet verschiedene Möglichkeiten, die Einwilligungsprozesse zu unterstützen und zu verbessern:

- Einholung der Einwilligung: Einwilligungen können direkt digital erfasst und unterschrieben werden. Alternativ können papierbasierte Einwilligungen eingescannt und erfasst werden, wodurch die Originale nur noch archiviert/gelagert werden müssen.

- Verwaltung der Einwilligung: Einwilligungen werden digital gespeichert und sind leicht erreichbar für Änderungen und Überprüfungen.

- Automatische Einwilligungsüberprüfung bei Datentransfers: Einwilligungsmanagement-Systeme ermöglichen das automatisierte Überprüfen auf eine Einwilligung für personenbezogene Daten

- Transparenz: Erfassung und Bearbeitung von Einwilligungen und deren Metadaten sind in Einwilligungsmanagement-Systemen einheitlich und ermöglichen das Etablieren von standardisierten Prozessen. Die Nachvollziehbarkeit und Standardisierung vereinfachen die Qualitätssicherung.

- Erhöhte Datenintegrität: Durch die Digitalisierung und Verlagerung in Datenbanken verringert sich das Risiko des Datenverlustes oder der irreparablen Beschädigung der einwilligungsbezogenen Daten, da durch Backups immer eine Wiederherstellung älterer Datensätze möglich ist.

- Betroffenenrechte: Ein systematisches und digitales Einwilligungsmanagement hilft bei der Wahrung der Betroffenenrechte der Studienteilnehmer (Art. 15-21 DSGVO), da benötigte Informationen leichter auffindbar und verwertbar sind.

Electronic Data Capture (EDC) / Electronic Case Report Form (eCRF)

Der Begriff Electronic Data Capture (EDC) bezeichnet Softwaresysteme, die für die elektronische Erfassung bzw. Erhebung von (klinischen) Forschungsdaten eingesetzt werden.

EDC-Systeme sind normalerweise webbasiert und ersetzen papierbasierte Case Report Forms (CRFs) durch entsprechende elektronische Darstellungen (eCRFs) bzw. papierbasierte Umfragen oder Selbstdokumentationen durch geeignete elektronische Varianten. EDC-Software beinhaltet neben den Eingabemasken in der Regel auch Workflow-Unterstützung in Form von Eingabeprüfungen (Data Entry Checks), Reporting/Statistikmodule, Exportmodule und Ähnliches.

Andere Begriffe, die in diesem Umfeld häufig verwendet werden, sind Remote Data Entry (RDE), Clinical Data Management System (CDMS) und Survey Tool.

Weitere Details finden Sie auch in den Glossar-Einträgen zu den Tools REDCap und SoSci Survey sowie auf unseren Service-Seiten.

European Open Science Cloud (EOSC)

Die European Open Science Cloud (EOSC) ist ein Projekt der Europäischen Kommission, um europäischen Wissenschaftlern Zugang zu wissenschaftlichen Daten, Datenverarbeitungsplattformen und Dienstleistungen für die Datenverarbeitung zu erleichtern.

The European Open Science Cloud (EOSC) ultimately aims to develop a 'Web of FAIR Data and services' for science in Europe upon which a wide range of value-added services can be built. These range from visualisation and analytics to long-term information preservation or the monitoring of the uptake of open science practices [1].

Unter anderem werden durch den EU Node (kostenlose) IT-Services für die Forschung bereitgestellt. Dies umfasst beispielsweise:

- File Sync and Share

- Interactive Notebooks (Jupyter)

- Large File Transfer

- Virtual Machines

- Cloud Container Platform

- Bulk Data Transfer

Außerdem enthält der Ressource Hub weit über 100 Mio. einzelne Einträge in den Kategorien:

- Publications

- Data

- Software

- Other Products

- Services

- Data Sources

- Training

- Interoperability Guidelines

- Tools

FAIR Data

Die FAIR Data Prinzipien sind im Kern schon lange in Richtlinien zur guten wissenschaftlichen Praxis enthalten. Explizit wurde FAIR Data von der Force11 publiziert und wird vor allem im Rahmen der GO FAIR Initiative weiter etabliert. In der deutschen Community bündeln sich die Aktivitäten dazu aktuell im Rahmen der Nationalen Forschungsdateninfrastruktur (NFDI).

Das Akronym FAIR setzt sich aus den folgenden Begriffen zusammen:

F - Findable: Um Daten nutzbar und wiederverwendbar zu machen, muss man sie finden können. Dazu sind maschinenlesbare und für die Suche geeignete Metadaten wichtig.

A - Accessible: Gefundene Daten müssen zugänglich sein. Dies betrifft unter anderem die Kommunikationsprotokolle und auch ggf. das Berechtigungsmanagement.

I - Interoperable: Die Meta-/Daten müssen in einer Form repräsentiert sein, die eine Integration mit anderen Daten und Tools erlaubt. Dies betrifft zum Beispiel die Wissensrepräsentation bzgl. Vokabularien, Referenzen, etc.

R - Reusable: Um eine Nachnutzung der Daten zu ermöglichen, müssen beispielsweise geeignete Lizenzen verwendet werden, die Quelle und Verarbeitungsschritte beschrieben sein (Data provenance) und relevante Domänen-/Community-Standards beachtet werden.

Forschungsdaten

Forschungsdaten sind einerseits das Ergebnis von wissenschaftlicher Forschungstätigkeit und stellen andererseits eine wichtige Grundlage für die wissenschaftliche Arbeit dar. Entsprechend der Vielfältigkeit von wissenschaftlicher Forschung umfassen Forschungsdaten sehr unterschiedliche Arten von Messwerten, Labordaten, Bild- oder Tonaufnahmen, Umfragedaten, Proben usw. Laut den von der Deutschen Forschungsgemeinschaft (DFG) veröffentlichten Leitlinien zum Umgang mit Forschungsdaten sollten auch methodische Testverfahren, z. B. Fragebögen, Software und Simulationen, als Forschungsdaten aufgefasst werden, wenn es sich bei diesen um ein zentrales Ergebnis der wissenschaftlichen Tätigkeit handelt.

Siehe auch Lebenszyklus von Forschungsdaten, Metadaten, FAIR Data.

Gute wissenschaftliche Praxis (GWP)

Wissenschaftliche Redlichkeit und die Beachtung der Grundsätze guter wissenschaftlicher Praxis sind unverzichtbare Voraussetzungen wissenschaftlichen Arbeitens, das Erkenntnisgewinn zum Wohl der Gesellschaft anstrebt.

Die Universität Oldenburg hat dazu die "Ordnung über die Grundsätze zur Sicherung guter wissenschaftlicher Praxis an der Carl von Ossietzky Universität" verabschiedet. Die Ordnung und weitere Informationen finden Sie auf den Seiten des Dekanats.

Die aktuelle Fassung des Kodex "Leitlinien zur Sicherung guter wissenschaftlicher Praxis" finden Sie auf den Seiten der DFG.

Die Servicestelle Forschungsdatenmanagement kann Sie insbesondere an den folgenden Punkten bei der Umsetzung der GWP unterstützen:

- Leitlinie 7: Phasenübergreifende Qualitätssicherung

Beratung bzgl. fachspezifischer Standards und etablierter Methoden im Bereich Forschungsdatenmanagement, Medizininformatik, Datenschutz, Informationssicherheit, etc.

Qualitätssicherung durch Gestaltung von Datenmanagementprozessen nach dem Stand der Technik bei der Erhebung, Prozessierung und Analyse von Forschungsdaten sowie Auswahl, Nutzung, ggf. Entwicklung und Programmierung von Forschungssoftware - Leitlinie 8: Akteure, Verantwortlichkeiten und Rollen

Soweit IT-Dienstleistungen genutzt werden, die von der Servicestelle administriert werden, übernehmen wir dafür für Sie die Pflege der Benutzerrollen. Die damit zusammenhängenden Rechte und Verantwortlichkeiten sind somit zu jedem Zeitpunkt des Forschungsvorhabens transparent. - Leitlinie 10: Rechtliche und ethische Rahmenbedingungen, Nutzungsrechte

Bzgl. der rechtlichen Zulässigkeit, Nutzungslizenzen und der technischen Umsetzung einer Zugänglichmachung von Forschungsdaten und -ergebnissen kann die Servicestelle Sie unterstützen. - Leitlinie 11: Methoden und Standards

Die Servicestelle kann Sie insbesondere in den Bereichen Forschungsdatenmanagement, Medizininformatik, Datenschutz, Informationssicherheit methodisch untersützen. Im Sinne der Leitlinie können Sie diese Kompetenzen zum Beispiel bei der Anwendung von Software und der Erhebung von Forschungsdaten für sich nutzen. - Leitlinie 12: Dokumentation

Durch die Nutzung von Datenmanagementplänen und Dokumentations-Tools sorgen Sie im Sinne der Leitlinie für die notwendigen Informationen über die Forschungsdaten und die Verarbeitungsschritte. - Leitlinie 13: Herstellung von öffentlichem Zugang zu Forschungsergebnissen

In diesem Punkt arbeitet die Servicestelle mit den zentralen Einrichtungen der Universität an Lösungen die FAIRe Veröffentlichung von Forschungsdaten besser zu unterstützen. - Leitlinie 16: Vertraulichkeit und Neutralität bei Begutachtungen und Beratungen

Die Verpflichtung zur Vertraulichkeit gilt natürlich auch für Beratungen durch die Servicestelle Forschungsdatenmanagement. - Leitlinie 17: Archivierung

Bei der Umsetzung der in der Regel 10-jährigen Aufbewahrungsfrist unterstützen wir Sie gerne.

Identitätsmanagement (Patientenliste, Anonymisierung, Pseudonymisierung, Treuhandhandstelle)

Identitätsmanagement dient in der medizinischen Forschung dazu medizinische Daten (MDAT) entsprechend den Grundsätze der DSGVO (insbesondere Artikel 5 Abs. 1 lit. c und e) datenschutzgerecht verarbeiten zu können. Identitätsmanagement ist nötig, wenn bei der Forschung nicht auf anonyme Daten zurückgegriffen werden kann, wie etwa bei der Zusammenführung von Daten aus verschiedenen Quellen oder bei longitudinalen Daten. Dieses Verfahren wird auch als Record-Linkage bezeichnet. Zu den zentralen Aufgaben des Identitätsmanagements gehören das Führen von Patientenlisten und die Pseudonymisierung.

Im dem Dokument „Praxishilfe zur Anonymisierung/Pseudonymisierung” [3] finden Sie weitere Definitionen, rechtliche Einordnungen, Umsetzungsempfehlungen, Praxisbeispiele, Checklisten, etc.

Patientenliste

In einer Patientenliste werden Personen mit ihren identifizierenden Personendaten (IDAT) erfasst und ihnen ein nichtsprechender Identifikator (PID) zugewiesen (in der Praxis häufig auch Studienpatientennummer o. Ä. genannt). Der PID dient beim Transfer von Behandlungs- oder Studiendaten in den Forschungskontext als Identifikator anstelle der IDAT.

Das Identitätsmanagement kann zentral oder dezentral organisiert sein. Das Führen von Patientenlisten kann im Sinne der Datensparsamkeit lokal in einem Forschungsprojekt betrieben werden. Bei größeren Forschungsverbünden mit Daten aus verschiedenen Quellen bietet es sich oft an Patientenliste und Pseudonymisierung über eine zentrale, unabhängige und vertrauenswürdige Stelle betreiben zulassen.

Anonymisierung

Eine Anonymisierung liegt vor, wenn der Personenbezug von Daten derart aufgehoben ist, dass er nicht oder nur unter unverhältnismäßigem Aufwand an Zeit, Kosten und Arbeitskräften wiederhergestellt werden kann. [2]

Pseudonymisierung

Die DSGVO fordert in Artikel 25 Pseudonymisierung, wenn personenidentifizierende Daten verarbeitet werden. Nach [1] werden verschiedene Klassen von Pseudonymen danach unterschieden, welcher Personenkreis von ihnen Kenntnis erhält. Durch mehrstufige Pseudonymisierung kann eine sichere Entkoppelung des Versorgungskontextes, einer Forschungsdatenbank und ggf. daraus abgeleiteter Extrakte erreicht werden.

Pseudonymisierungsdienst

Sollen medizinische Daten aus verschiedenen Quellen zusammengeführt werden, so geschieht dies mittels Pseudonymisierung. Hierbei wird einem PID aus dem Identitätsmanagement ein permanentes Pseudonym (PSN) zugeordnet. Die zugehörigen MDAT werden an einem Pseudonymisierungsdienst vorbei oder verschlüsselt durchgeleitet.

Ein Pseudonymisierungsdienst stellt in diesem Kontext eine Softwarelösung dar, welche das automatische Pseudonymisieren von Daten ermöglicht. Diese Systeme bieten in der Regel das automatische Erzeugen, Speichern und Verwalten von Pseudonymen und Zuordnungen von Originalwerten zu Pseudonymen. Es gibt sowohl einfache Desktop-Anwendungen für kleine lokale Forschungsvorhaben als auch komplexe Client-Server-Architekturen für verteilte Forschungsverbünde.

Treuhandstelle / Vertrauenswürdige Stelle

Eine Treuhandstelle dient in der medizinischen Forschung als unabhängige Einrichtung für die Trennung von personenidentifizierenden Daten und medizinischen Daten. Im Glossareintrag Repositorium finden Sie Informationen zum Treuhandstellen-Begriff im nicht-medizinischen Kontext, der in der Datenstrategie der Bundesregierung Verwendung findet.

Durch eine Treuhandstelle können Forschern Daten ohne einen direkten Personenbezug so zur Verfügung gestellt werden, dass sie trotzdem weiterhin über Pseudonyme verknüpfbar sind. Treuhandstellen können lokal, verteilt oder zentral betrieben werden. Neben dem Führen einer Patientenliste und der Pseudonymisierung oder Anonymisierung von Daten kann sich eine Treuhandstelle auch mit der Verwaltung von Einverständniserklärungen von Patienten und Probanden befassen.

Die UOL hat Anfang 2022 die Einrichtung der unabhängigen (Daten-)Treuhandstelle der Carl von Ossietzky Universität Oldenburg beschlossen.

Für viele der Aufgaben unter dem Oberbegriff Identitätsmanagement können Software-Lösungen zur leichteren Umsetzung angeboten werden. So könnte ein Pseudonymisierungsdienst das systematische und automatische Pseudonymisieren von Daten übernehmen.

Die Angebote der Servicestelle FDM finden Sie im Service-Bereich und bei der Treuhandstelle. Wir beraten Sie darüber hinaus gerne bei der individuellen Gestaltung der Prozesse in Ihrem Projekt.

- Pommerening, K.; Drepper, J.; Helbing, K.; Ganslandt, T. (2014): Leitfaden zum Datenschutz in medizinischen Forschungsprojekten – Generische Lösungen der TMF 2.0, Schriftenreihe der TMF Band 11, MWV, Berlin.

- Der Bundesbeauftragte für den Datenschutz und die Informationsfreiheit (2020): Öffentliches Konsultationsverfahren des Bundesbeauftragten für den Datenschutz und die Informationsfreiheit zum Thema: Anonymisierung unter der DSGVO unter besonderer Berücksichtigung der TK-Branche, Bonn

- Praxishilfe zur Anonymisierung/Pseudonymisierung der GMDS-AG „Datenschutz und IT-Sicherheit im Gesundheistwesen” und des BvD (Stand: 27.01.2024) https://gesundheitsdatenschutz.org/html/pseudonymisierung_anonymisierung.php

Investigator Initiated Trials (IIT) / Wissenschafts-initiierte (klinische) Studien

Investigator Initiated Trials (IITs) sind klinische Studien oder biomedizinische Forschungsprojekte, bei denen die Verantwortung (i. e. Sponsorschaft nach dem Arzneimittelgesetz) und die Studienleitung bei universitären Einrichtungen liegt. Im Gegensatz dazu werden Zulassungsstudien im Arzneimittel- oder Medizinprodukte-Bereich normalerweise von der (Pharma-)Industrie in Zusammenarbeit mit Contract Research Organizations (CROs) durchgeführt.

Typische Beispiele für IITs sind Therapie-Vergleiche oder Therapie-Optimierungsstudien, für die oft kein kommerzielles, aber ein hohes wissenschaftliches Interesse vorhanden ist.

Finanziert werden IITs häufig durch öffentliche Fördermaßnahmen, wie z. B. von BMBF oder DFG , durch Stiftungen und teilweise auch durch die Industrie.

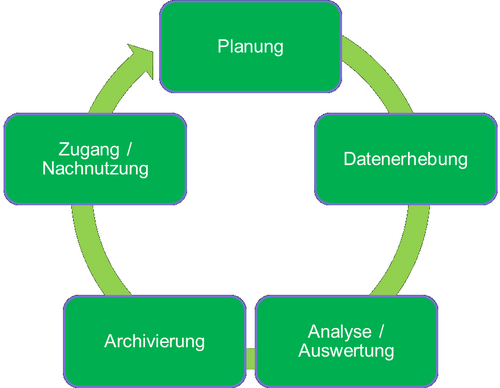

Lebenszyklus von Forschungsdaten

Der Lebenszyklus von Forschungsdaten erstreckt sich von der Planung eines Forschungsvorhabens über die Generierung und Analyse von Forschungsdaten bis zur Archivierung und Nutzbarmachung von Forschungsdaten. In dem Lebenszyklus von Forschungsdaten lassen sich verschiedene generische Phasen identifizieren:

Planung: Der Startpunkt eines Forschungsvorhabens ist immer eine Forschungsfrage. Zur Beantwortung dieser Frage werden in der evidenzbasierten Forschung Daten benötigt. Hierbei entsteht eine Vielzahl an Aufgaben:

- Recherche nach existierenden Daten und Datenzugriffsmöglichkeiten

- Klärung von Datenlizenzfragen

- Planung von Datenerhebung

- Planung des Forschungsdatenmanagements, unter anderem:

- Planung Datenzugriff

- Planung Datenpublikation

- Planung Datenarchivierung

Beim Forschen mit Forschungsdaten bietet es sich an, systematisches Forschungsdatenmanagement zu betreiben, in der Planungsphase einen Datenmanagementplan zu erstellen und diesen während des Forschungsvorhabens kontinuierlich zu pflegen.

- Datenerhebung: Die Datenerhebung umfasst Aufgaben von der reinen Akquise von existierenden Daten bis zur Erhebung von neuen Daten (z. B. durch Experimente oder Umfragen). Bei der Erhebung neuer Daten können je nach Forschungsvorhaben Softwarewerkzeuge genutzt werden. Dies können EDC-Lösungen wie REDCap oder Umfrage-Server wie SoSci Survey sein. Des Weiteren gehört zur Datenerhebung auch die Erhebung von Metadaten zur Beschreibung der Daten und des Erhebungskontextes und das Verwalten und Speichern von Daten.

- Analyse/Auswertung: Für die Analyse und Auswertung der Forschungsdaten müssen die Forschungsdaten überprüft, validiert und gegebenenfalls bereinigt werden. Dies stellt eine Schnittstelle zwischen Datenerhebung und Auswertung dar. Im Anschluss können die Forschungsdaten analysiert und interpretiert werden. Die dabei gewonnenen Erkenntnisse liegen oft in Form von Analyse-Daten vor und sind ebenfalls Forschungsdaten.

- Archivierung: Nach Analyse/Auswertung und gegebenenfalls Publikation von wissenschaftlichen Ergebnissen müssen die Forschungsdaten archiviert werden. Die Archivierung sollte bereits in der Planungsphase vorbereitet und in einem Datenmanagementplan dokumentiert sein. Zu den Aufgaben der Archivierung gehören die Auswahl eines Archives und/oder einer Archivierungsmethode, Wahl eines passenden Speicherformates und entsprechende Dokumentation. Des Weiteren kann die Archivierung noch Aufgaben der Datenaufbereitung, wie Anonymisierung von Datensätzen, beinhalten.

- Zugang/Nachnutzung: Zugang und Nachnutzung zu und von Forschungsdaten richten sich nach den FAIR-Prinzipien. Zur Zugänglichmachung von Forschungsdaten für die wissenschaftliche Nachnutzung gehören die Publikation von Forschungsdaten in einem erreichbaren Forschungsdatenrepository und die Vergabe von Nutzungslizenzen für die Forschungsdaten. Zu Beginn dieser Phase ist auch die rechtliche Frage zu klären, in welcher Form die Forschungsdaten überhaupt zugänglich gemacht werden dürfen. Besonders im Rahmen von medizinischer Forschung sind hier oft datenschutzrechtliche Hürden zu bedenken.

Medizinische Terminologien

In der medizinischen Forschung und Versorgung besteht ein hoher Bedarf an semantischer Interoperabilität für den Austausch der medizinischen Daten. Die semantische Interoperabilität soll hierbei den Bedeutungserhalt beim Informationsaustausch zwischen Menschen und Maschinen sicherstellen. Beispiele für medizinische Terminologien sind:

- ICD: Die International Statistical Classification of Diseases and Related Health Problems (ICD) ist ein wichtiges weltweit anerkanntes Klassifikationssystem für medizinische Diagnosen. Die deutsche Version der momentan gültigen ICD Version 10: https://www.bfarm.de/DE/Kodiersysteme/Klassifikationen/ICD/ICD-10-GM/_node.html

- LOINC: Logical Observation Identifiers Names and Codes (LOINC) ist ein internationales, primär englischsprachiges System zur eindeutigen Verschlüsselung von medizinischen Untersuchungen, insbesondere von Laboruntersuchungen: loinc.org/

- SNOMED CT: Systematized Nomenclature of Medicine Clinical Terms (SNOMED CT) – übersetzt Systematisierte Nomenklatur der Medizin – gehört derzeit zu den umfassendsten und wichtigsten medizinischen Terminologien weltweit: www.snomed.org/

Medizinprodukte / Medizinprodukterecht-Durchführungsgesetz (MPDG) / Medical Device Regulation (MDR)

Medizinprodukte sind Produkte mit medizinischer Zweckbestimmung, die vom Hersteller für die Anwendung beim Menschen bestimmt sind.

Dazu gehören Implantate, Produkte zur Injektion, Infusion, Transfusion und Dialyse, humanmedizinische Instrumente, Software, Katheter, Herzschrittmacher, Dentalprodukte, Verbandstoffe, Sehhilfen, Röntgengeräte, Kondome, ärztliche Instrumente, Labordiagnostika, Produkte zur Empfängnisregelung sowie In-vitro-Diagnostika.

Zu den In-vitro-Diagnostika zählen Reagenzien, Reagenzprodukte, Kits, Probenbehältnisse, Geräte und weitere Produkte, die zur In-vitro-Untersuchung von Proben aus dem menschlichen Körper bestimmt sind.

Medizinprodukte sind auch Produkte, die einen Stoff oder Zubereitungen aus Stoffen enthalten oder mit solchen beschichtet sind, die bei gesonderter Verwendung als Arzneimittel oder Bestandteil eines Arzneimittels (einschließlich Plasmaderivate) angesehen werden und in Ergänzung zu den Funktionen des Produktes eine Wirkung auf den menschlichen Körper entfalten können.

Anders als bei Arzneimitteln, die pharmakologisch, immunologisch oder metabolisch wirken, wird die bestimmungsgemäße Hauptwirkung bei Medizinprodukten primär auf physikalischem Weg erreicht [1].

Zweck der Regelungen (im Forschungskontext) ist unter anderem sicherzustellen, dass die im Rahmen klinischer Prüfungen gewonnenen Daten zuverlässig und solide sind und dass die Sicherheit der an klinischen Prüfungen teilnehmenden Prüfungsteilnehmer geschützt wird.

Die gesetzlichen Grundlagen hierzu sind u. a. die Medical Device Regulation (MDR) und das Medizinprodukterecht-Durchführungsgesetz (MPDG).

Bzgl. der regulatorischen Einstufung von Studien und den daraus resultierenden Anforderungen wenden Sie sich bitte an das KKS.

Metadaten

Metadaten sind strukturierte Daten, die Informationen über Merkmale anderer Daten enthalten. Im Kontext von Forschungsdaten zählen Angaben über die Entstehung/Gewinnung und Verarbeitung der Daten zu den wichtigsten Metadaten. Dies reicht von allgemeinen projektbezogenen Informationen (Forschungsgebiet, Projektleiter, Förderung,…) bis zu detaillierten technischen Informationen bei bildgebenden oder (labor-)analytischen Verfahren.

Umfangreiche allgemeine Informationen zum Thema Forschungsdaten mit vielen Quellen und Verweisen finden Sie im Artikel Metadaten und Metadatenstandards.

Einen guten Einstieg mit praktischen Tipps bietet außerdem die englischsprachige Publikation 5 Steps to Better Metadata .

Metadaten sind eine wichtige Grundlage für FAIR Data.

Nationale Forschungsdateninfrastruktur (NFDI)

Die Nationale Forschungsdateninfrastruktur ist eine Förderinitiative, die unter der Koordination der DFG deutschlandweit ein verlässliches und nachhaltiges Dienste-Portfolio für generische und fachspezifische Bedarfe des Forschungsdatenmanagements entwicklen soll.

Die nationale Forschungsdateninfrastruktur (NFDI) soll die Datenbestände von Wissenschaft und Forschung systematisch erschließen, nachhaltig sichern und zugänglich machen sowie (inter-)national vernetzen. Sie wird in einem aus der Wissenschaft getriebenen Prozess als vernetzte Struktur eigeninitiativ agierender Konsortien aufgebaut werden.

Die Ziele der Förderung von Konsortien sind:

- Etablierung von Regeln zum standardisierten Umgang mit Daten in enger Rückkoppelung mit der jeweiligen Fachgemeinschaft

- Erarbeitung von disziplinübergreifenden Metadatenstandards

- Entwicklung von verlässlichen und interoperablen Maßnahmen für das Datenmanagement und ein auf die Anforderungen der Fachgemeinschaft zugeschnittenes Dienste-Angebot

- Steigerung der Nachnutzbarkeit bereits vorhandener Daten, auch über die Fächergrenzen hinaus

- Anbindung und Vernetzung mit Partnern in ausländischen Wissenschaftssystemen, die Kompetenz im Bereich Forschungsdatenmanagement aufweisen.

- Mitarbeit bei der Entwicklung und Etablierung generischer, konsortienübergreifender Dienste und Standards zum Forschungsdatenmanagement [1]

Auf europäischer Ebene kooperiert die NFDI mit der EOSC. Gemeinsam mit Kollegen aus dem BIS, dem Referat Forschung und Transfer und den IT-Diensten verfolgt die Servicestelle Forschungsdatenmanagement die Entwicklungen in diesem Bereich und informiert über Angebote und Lösungen.

Personenbezogene Daten

Personenbezogene Daten sind nach Artikel 4 Datenschutzgrundverordnung (DSGVO) alle Informationen, die sich auf eine identifizierte oder identifizierbare Person beziehen.

Gesundheitsdaten in Form von Einzelangaben (z. B. eine Tabelle mit einer Zeile pro Person) sind somit in der Regel personenbezogene Daten. Auch wenn kein direkt identifizierendes Merkmal (z. B. der Name) oder ein Pseudonym (z. B. eine Fallnummer) enthalten ist, kann eine Person noch identifizierbar sein.

Für die Verarbeitung personenbezogener Daten wird eine Rechtsgrundlage (wie z. B. die Einwilligung des Betroffenen) benötigt. Dies ist dann besonders wichtig, wenn Daten für die Forschung verwendet und an Dritte übermittelt werden sollen, die aus anderen Gründen (wie z. B. der medizinischen Versorgung) erhoben wurden.

Bei medizinischen Daten handelt es sich gemäß Artikel 9 der DSGVO regelmäßig um sogenannte "besondere Kategorien personenbezogener Daten". Insbesondere fallen genetische Daten, biometrische Daten und Gesundheitsdaten darunter. Diese Arten von Daten gelten als besonders sensibel und erfordern daher zusätzliche Maßnahmen.

Gerne berät Sie die Servicestelle Forschungsdatenmanagement zu speziellen Aspekten im Umgang mit medizinischen Forschungsdaten. Relevant ist in diesem Zusammenhang z. B. auch das Thema Identitätsmanagement.

Weitere Details und Beratung finden Sie außerdem auf den Seiten der Stabsstelle Datenschutz- und Informationssicherheitsmanagement.

REDCap

REDCap ist eine browserbasierte EDC-Software zum Aufbau und zur Verwaltung von klinischen und translationalen Forschungsdatenbanken. Die Datenerfassung erfolgt komfortabel und einfach über eine benutzerfreundliche Oberfläche mit Hilfe von Online-Umfragen oder eCRFs .

Die erhobenen Daten können als CSV oder XML oder direkt im Format für diverse Statistik-Tools (SPSS, SAS, R, Stata) exportiert werden. Weiterhin bietet REDCap die Offline-Datenerhebung per App, einen Audit Trail, das Abrufen von Reports und Statistiken, Erweiterbarkeit durch Plugins u. v. m.

Eine ausführliche Liste der enthaltenen Funktionen ist auf der offiziellen Webseite zu finden: projectredcap.org/software/

Zu beachten ist, dass die Software nicht für Studien, die dem Arzneimittelgesetz (AMG) oder dem Medizinproduktegesetz (MPG) unterliegen, validiert ist.

REDCap wurde 2004 an der Vanderbilt University implementiert und wird seitdem stetig vom REDCap-Konsortium weiterentwickelt.

Informationen zu unserem REDCap-Service finden Sie in unserem Service-Bereich.

Repositorium

Unter einem Repositorium wird im Forschungskontext ein Speicherort für Forschungsdaten (z. B. Rohdaten, methodische Informationen, Publikationen; vgl. auch Glossar-Eintrag) verstanden. Es kann genutzt werden, um Forschungsdaten der Öffentlichkeit zugänglich zu machen und sie für einen begrenzten Zeitraum aufzubewahren oder sie dauerhaft zu archivieren. Das Veröffentlichen von Forschungsdaten in einem Repositorium ist im Sinne der Guten wissenschaftlichen Praxis (GWP) und den FAIR-Data-Prinzipien und vereinfacht die Auffindbarkeit und Nachnutzung der Daten durch andere Forscher erheblich. Neben allgemeinen Repositorien gibt es Fachrepositorien, die sich auf eine bestimmte Fachdisziplin und die Besonderheiten der jeweiligen Daten spezialisiert haben und institutionelle Repositorien, die nur für Mitglieder der jeweiligen Institution zugänglich sind. An der Universität Oldenburg wird ein solches Repositorium mit dem Namen DARE vom BIS zur Verfügung gestellt.

Werden die Forschungsdaten oder die Publikationen im Repositorium eingetragen, wird ihnen i. A. ein persistenter Identifikator (PID) zugewiesen. Dieser ermöglicht es, dass die Daten und Publikationen auch bei Änderung des Speicherorts stets referenzierbar und zitierfähig bleiben. Häufig verwendet werden hierfür der DOI (Digital Object Identifier) und der URN (Uniform Resource Name). Damit die Daten auffindbar und nachnutzbar sind, müssen die Daten ausreichend durch Metadaten beschrieben werden. Die Metadaten enthalten auch die Lizenzen, die angeben, unter welchen Bedingungen die Daten verwendet werden dürfen. Hier kann es auch spezielle Vorgaben durch den Repositoriums-Betreiber geben. Vor der Aufnahme ins Repositorium sollten insbesondere rechtliche Aspekte beachtet werden (Urheberrecht, Zweitveröffentlichung, Datenschutz). Teilweise findet eine Prüfung hiervon durch den Betreiber statt, ebenso wie die Datenkuration (Qualitätskontrolle von Inhalt, Metadatenannotation, Datenformat, etc.).

Forschungsdatenrepositorien lassen sich über Forschungsdaten-Repository-Register finden, wie z. B. das Registry of research data repositories [1].

Im Zusammenhang der Bereitstellung von FAIRen Daten durch öffentliche Repositorien ist die aktuelle politische Entwicklung in diesem Bereich erwähnenswert. Am 27. Januar 2021 wurde die Datenstrategie der Bundesregierung mit rund 240 Maßnahmen beschlossen, welche als Ziel hat „die Bereitstellung und Nutzung von Daten durch Personen und Institutionen […] signifikant zu steigern, keine neuen Datenmonopole entstehen zu lassen, eine gerechte Teilhabe zu sichern und zugleich Datenmissbrauch konsequent zu begegnen“ [2]. Hier ist die Rede von sogenannten Datentreuhandstellen, welche als neutrale Stellen zur Verwaltung und Bereitstellung von Daten vorgesehen sind und so gewissermaßen die Funktionen eines Repositoriums erfüllen. Weitere Informationen und die vollständige Fassung der Datenstrategie sind auf der Webseite der Bundesregierung [3] zu finden. Die Europäische Kommission hat sich ebenfalls dafür ausgesprochen gemeinsame europäische Datenräume und daraus entstehende Datenpools in strategischen Wirtschaftszweigen und Bereichen von öffentlichem Interesse zu fördern [4].

Der Rat für Informationsinfrastrukturen (RfII) hat eine Stellungnahme zur Gestaltung solcher Datentreuhandstellen veröffentlicht. Generell spricht sich der RfII für das System der Treuhandstellen aus, betont aber, dass der Aufbau einer Treuhänderrolle mit vielen Anforderungen verbunden ist. Daher wird der Erfahrungsaustausch mit der Wissenschaft empfohlen, welche bereits umfangreiche Erfahrung mit dem Teilen von qualitätsgesicherten Daten unter der Berücksichtigung der Rechte von Datengebern und dem Betrieb von Treuhandstellen hat. Der wissenschaftliche Datenbestand kann sich von Unternehmens- und Verbraucherdaten unterscheiden. Beiden gemein ist aber die Erfüllung von Qualitätsmerkmalen wie Vertrauenswürdigkeit, Rechtskonformität und Transparenz des Zugangs. Zur Klärung der Begrifflichkeiten ist anzumerken, dass der Treuhandbegriff sowohl in der Wissenschaft als auch in der Wirtschaft oft von der streng juristischen Definition einer Treuhänderschaft abweicht. So können Treuhandstellen z. B. auch weitere Aufgaben wie etwa die Pseudonymisierung oder Anonymisierung wahrnehmen [5]. In der medizinischen Forschung dienen Treuhandstellen zur Trennung von medizinischen und personenidentifizierenden Daten.

Die vollständige Stellungnahme ist auf der Webseite des RfII zu finden.

- www.forschungsdaten.info/themen/veroeffentlichen-und-archivieren/repositorien/

- Die Bundesregierung (2019): Eckpunkte einer Datenstrategie, S. 1.

- www.bundesregierung.de/breg-de/themen/digitalisierung/datenstrategie-beschlossen-1842786

- Europäische Kommission (2020): Eine europäische Datenstrategie. Mitteilung der Kommission an das Europäische Parlament, den Rat, den Europäischen Wirtschafts- und Sozialausschuss und den Ausschuss der Regionen, Brüssel, S. 25.

- Stellungnahme des Rates für Informationsinfrastrukturen (RfII): Datentreuhandstellen gestalten – Zu Erfahrungen der Wissenschaft (2020); www.rfii.de/?p=4259

Software as a Service (SaaS)

Software as a Service ist ein Teilbereich des Cloud Computing. Dieser ist laut dem Bundesamt für Sicherheit in der Informationstechnik (BSI) wie folgt definiert:

Cloud Computing bezeichnet das dynamisch an den Bedarf angepasste Anbieten, Nutzen und Abrechnen von IT-Dienstleistungen über ein Netz. Angebot und Nutzung dieser Dienstleistungen erfolgen dabei ausschließlich über definierte technische Schnittstellen und Protokolle. Die Spannbreite der im Rahmen von Cloud Computing angebotenen Dienstleistungen umfasst das komplette Spektrum der Informationstechnik und beinhaltet unter anderem Infrastruktur (z. B. Rechenleistung, Speicherplatz), Plattformen und Software. [1]

SaaS befasst sich hierbei mit dem Teilbereich der Bereitstellung von Software als Dienstleistung für den Anwender. Für den Anwender fallen somit der Betrieb und die grundlegende Administration von IT-Systemen sowie der jeweiligen Anwendung weg. SaaS ermöglicht es dem Anwender sich auf die fachliche Nutzung der jeweiligen Softwarelösung für ein Vorhaben zu fokussieren.

Software Management Plan / Software Engineering Guideline

Wenn im Rahmen eines Forschungsprojekts Software entwickelt wird, sollte (analog zu einem Datenmanagementplan) ein Softwaremanagementplan erstellt werden. Software kann unterschiedlich umfangreich und komplex sein, von kurzen Shell-Scripten, über umfangreiche Auswertungsprogramme bis hin zu komplexen Softwareentwicklungsprojekten. Je nach Komplexität und insbesondere auch nach der Zweckbestimmung/Anwendungsklasse gibt es unterschiedliche Empfehlungen.

Eine Dokument mit umfangreichen Empfehlungen und Checklisten jeweils in deutscher und englischer Sprache unter CC-BY-Lizenz gibt es von der DLR Software Engineering Initiative [1].

Auch beim Software Sustainability Institute [2] gibt es eine empfehlenswerte Übersichtsseite mit verlinkten Vorlagen und Informationen.

SoSci Survey

Bei SoSci Survey handelt es sich um ein professionelles browserbasiertes Werkzeug zur Entwicklung und Durchführung von Online-Befragungen. Die Grundlage für SoSci Survey entstand 2003 am Institut für Kommunikationswissenschaft und Medienforschung der LMU München. Seitdem wird SoSci Survey stetig von der SoSci Survey GmbH weiterentwickelt.

SoSci Survey ermöglicht die Erstellung anspruchsvoller Online-Fragebögen, indem u.a. Bilder, Audio- und Videodateien in den Fragebogen eingebunden werden können und über 30 Fragetypen für eine flexible Gestaltung zur Verfügung stehen. Die erhobenen Daten können in diversen Formaten wie etwa CSV, SPSS, Stata, GNU R oder SQL zur Weiterverarbeitung exportiert werden. Weitere Informationen sind auf der offiziellen Homepage zu finden: www.soscisurvey.de/

Die Nutzung von SoSci Survey ist für die nicht-kommerzielle Forschung kostenlos. Die Universität Oldenburg stellt hierfür einen eigenen Befragungsserver mit SoSci Survey bereit. Die Servicestelle Forschungsdatenmanagement bietet die Möglichkeit, SoSci Survey an der Universität Oldenburg für eigene Online-Befragungen zu verwenden.

Informationen zu unserem SoSci Survey-Service finden Sie in unserem Service-Bereich.

Standard Operating Procedure (SOP)

Standard Operating Procedures (SOPs) sind verbindlich dokumentierte Arbeitsabläufe bzw. Prozessbeschreibungen. SOPs sind ein wichtiger Bestandteil eines GCP-konformen Qualitätsmanagementsystems.

Zu einem SOP-System gehört dementsprechend u. a. auch ein Rollenmodell und ein Schulungskonzept. Eine SOP sollte genau ihren Zweck und Anwendungsbereich definieren sowie die relevanten regulatorischen Vorgaben und die durchzuführenden Arbeitsschritte incl. zu erstellender Dokumentation beschreiben.

Häufig werden SOPs durch weitere Arbeitsanweisungen (engl. work instruction) ergänzt, in denen beispielsweise systemspezische Arbeitsschritte detaillierter beschrieben werden ggü. den eher allgemeingültigen Vorgaben einer SOP.

TMF e. V.

Die TMF – Technologie- und Methodenplattform für die vernetzte medizinische Forschung e.V. (kurz: TMF) ist die Dachorganisation für die medizinische Verbundforschung in Deutschland. Sie ist die Plattform für den interdisziplinären Austausch und die projekt- wie standortübergreifende Zusammenarbeit, um gemeinsam die organisatorischen, rechtlich-ethischen und technologischen Probleme der modernen medizinischen Forschung zu identifizieren und zu lösen. Die Lösungen reichen von Gutachten, generischen Konzepten und IT-Anwendungen über Checklisten und Leitfäden bis zu Schulungs- und Beratungsangeboten. Die TMF stellt diese Lösungen frei und öffentlich zur Verfügung. [1]

Die medizinische Fakultät ist Mitglied in der TMF und möchte die Angebote für die Angehörigen der UOL nutzbar machen. Mitarbeiter der Servicestelle nehmen regelmäßig an Arbeitsgruppen-Treffen der TMF teil und stehen Ihnen gerne für Fragen oder zum Aufbau von Kontakten / Kooperationen zur Verfügung.