Sind Verfahren der Künstlichen Intelligenz (KI) geeignet, um kinderpornografische Bilder auf Endgeräten automatisch zu erkennen? Eine Studie, an der der Oldenburger Informatiker Daniel Neider beteiligt war, weckt daran Zweifel.

Herr Neider, haben Sie einen Antivirenscanner auf Ihrem Computer?

Ich glaube, jeder Windows-Computer ist mit einem Antivirenprogramm ausgestattet – also ja.

Apple hat im vergangenen Jahr versuchsweise das Programm NeuralHash auf Endgeräte aufgespielt, das Bilddateien automatisch nach kinderpornografischem Material durchsuchen soll. Kann man sich das so ähnlich vorstellen wie ein Antivirenprogramm?

Von der Sache her tut NeuralHash etwas Ähnliches, auch wenn es technisch anders funktioniert: Die Software durchsucht Endgeräte auf bestimmte Inhalte – nicht, wie Antivirenprogramme, auf Schadsoftware, sondern auf strafrechtlich relevantes Bildmaterial. Man nennt das Client-Side-Scanning, also das Scannen von Dateien auf Kundenseite.

Wie funktioniert NeuralHash genau?

Das Programm beruht auf Verfahren der Künstlichen Intelligenz und setzt sogenannte neuronale Netze ein. Vereinfacht gesagt handelt es sich um ein Computerprogramm, das darauf trainiert ist, gewisse Muster in Bildern zu erkennen. Dieses Programm ordnet jedem Bild eine Art Code zu, im Prinzip eine Abfolge von Zahlen und Buchstaben. Diese Codes werden Hashes genannt. Man kann sich das so vorstellen, als ob man für jedes Bild eine Art Fingerabdruck generiert. Der Trick besteht darin, dass Bilder, die ähnlich aussehen, den gleichen Hash bekommen – also beispielsweise könnten alle Bilder mit schwarzen Katzen dem Hash 3x580ac97e zugeordnet werden. Bei Apple existiert eine große Datenbank mit solchen Hashes, die sich kinderpornografischen Bildern zuordnen lassen. Und wann immer ein Nutzer versucht, ein Bild mit einem Hash hochzuladen, der in dieser Datenbank enthalten ist, dann wird das Bild markiert, ohne dass der Nutzer etwas davon mitbekommt. So ein Bild kann man dann nicht weiterleiten.

Das heißt, Apple weiß, was für Bilder auf meinem Handy sind?

Nein, Apple guckt sich die Bilder nicht an, dort existiert nur die Datenbank mit den Codes. Die Idee ist, dass der Konzern mit NGOs zusammenarbeitet, die Kinder schützen wollen. Und anhand von Material, das von Strafverfolgungsbehörden stammt, generieren diese Organisationen mittels eines Programms Hashes für die Datenbank.

Sie haben sich in einem Forschungsprojekt gemeinsam mit Kollegen von der Uni Darmstadt mit NeuralHash befasst. Was war der Hintergrund?

Neuronale Netze funktionieren nicht immer so, wie man sich das vorstellt. Die Technologie verspricht sehr viel, arbeitet aber nicht immer hundertprozentig korrekt. Warum sie ein bestimmtes Ergebnis liefert, lässt sich oft schwer herausfinden, weil die Vorgehensweise nicht explizit programmiert worden ist. Im Prinzip hat diese Technologie einfach gewisse Muster in den Daten gelernt. Das kann man wiederum ausnutzen, um das Programm auszutricksen, was erschreckend häufig auch funktioniert. Daher haben wir uns die Frage gestellt: Wie ist das bei einem System, das später strafrechtlich relevante Dinge beurteilen soll? Was passiert beispielsweise, wenn man Bilder leicht verändert?

Wieso haben Sie NeuralHash in den Blick genommen?

Apple hatte 2021 einen Prototyp von NeuralHash mit einem Update des Betriebssystems auf Endgeräte ausgeliefert – im Prinzip alle Geräte, die Fotos an den Cloudspeicherdienst iCloud senden können, etwa iPhones oder Macs. Dieser Prototyp war noch nicht eingeschaltet, das Programm hat also auf den Apple-Geräten noch keine Bilder überprüft. Doch dadurch war die Technologie auch für uns verfügbar, wir konnten das Programm extrahieren und hatten somit Zugriff auf das neuronale Netz. Wir wollten uns anschauen, wie eine große Firma so eine Aufgabe umsetzen würde. Apple hat später davon abgesehen, NeuralHash offiziell auszurollen, weil es massive Kritik an der massenhaften Überwachung und dem starken Eingriff in die Privatsphäre gab.

Was genau haben Sie untersucht?

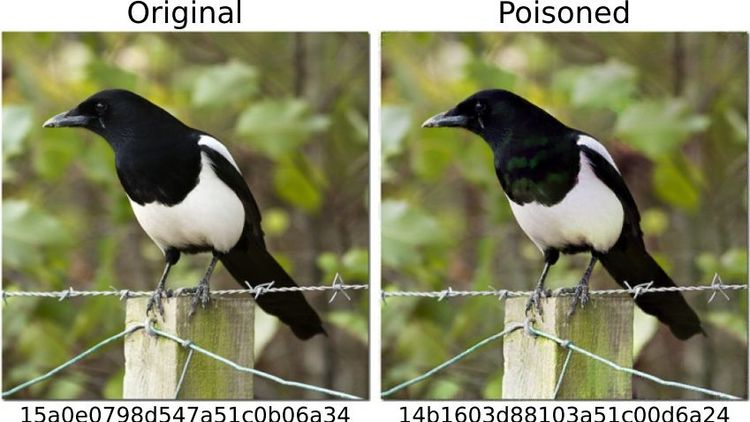

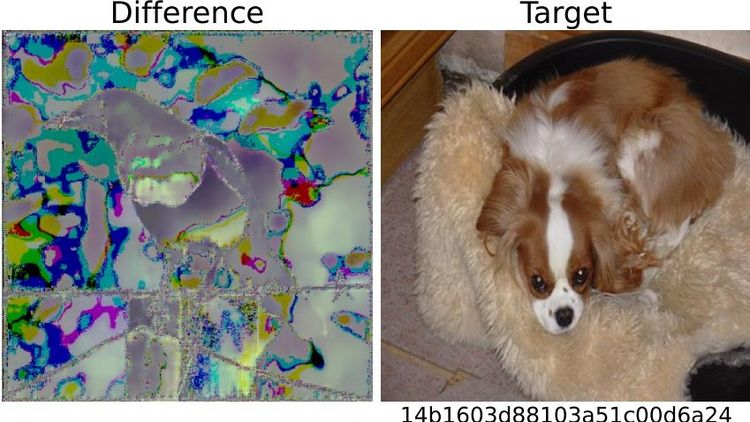

Wir haben getestet, wie man mit diesem System Schindluder treiben könnte. Um nicht mit kinderpornografischem Material arbeiten zu müssen, haben wir Bilder von Hunden als „gefährlich“ definiert. Dann haben wir die „digitalen Fingerabdrücke“ davon berechnet. Im ersten Szenario haben wir andere Bilder, zum Beispiel von einer Katze, genommen und versucht, sie leicht abzuändern, so dass hinterher ein „Fingerabdruck“ von einem Hund herauskommt.

Hat es funktioniert?

Ja, es stellte sich heraus, dass man das relativ leicht machen kann. Man braucht dazu zwar Zugang zum neuronalen Netzwerk – was wir hatten, weil das Programm ja auf den Geräten installiert war – und man braucht ein bisschen Ahnung, wie maschinelles Lernen funktioniert. Aber dann ist es relativ einfach, die Katzenbilder so zu verändern, dass sie einen beliebigen anderen Hash generieren. Die manipulierten Fotos sehen für das menschliche Auge fast so aus wie das Original, man kann eigentlich keinen Unterschied erkennen.

Und damit wird es dann problematisch…

Richtig. Ich könnte Ihnen nämlich solch ein manipuliertes Foto schicken. Und in dem Moment, in dem Sie versuchen, das in Ihre Cloud hochzuladen oder per Messenger an jemand anderen weiterzusenden, wird das System getriggert, ohne dass Sie das merken. Sie wissen gar nicht, warum das Hochladen oder Weiterleiten blockiert wird. Der Punkt ist: Auch Apple bekommt mit, dass Sie versucht haben, ein verdächtiges Bild zu versenden. Und wenn das zu häufig passiert, dann entschlüsselt Apple das Material und informiert gegebenenfalls die örtlichen Strafverfolgungsbehörden. Das heißt: Man könnte jemandem irgendwelches Material unterschieben, um ihn anzuschuldigen.

Was haben Sie noch untersucht?

Wir haben uns umgekehrt gefragt: Kann ich dem System entkommen? Kann ich ein Bild mit einem Fingerabdruck in der Datenbank so manipulieren, dass es einen anderen Fingerabdruck bekommt? In einem Szenario haben wir wieder angenommen, dass man über sein Gerät Zugriff auf die KI hat, das neuronale Netz kennt und sich ein bisschen mit maschinellem Lernen auskennt.

Und kann man damit die Bilder so manipulieren, dass sie unverdächtig erscheinen?

Ja, das funktioniert sehr gut. Was wir aber auch festgestellt haben: Selbst, wenn wir keinen Zugriff auf das System haben und ganz einfache Dinge mit einem Foto machen, die jeder mit seinem Handy machen kann, ist es möglich, das Programm zu überlisten. Wenn Sie zum Beispiel ein Bild um 90 Grad drehen, dann können Sie den „Fingerabdruck“ sehr stark verändern. Das ist natürlich nicht gut, denn diese Veränderung können Sie einfach wieder rückgängig machen, indem Sie das Bild in die andere Richtung um 90 Grad drehen. Die gesamte Bildinformation bleibt erhalten. Das zeigt, dass es relativ leicht ist, das System auszuhebeln.

Welche Schlüsse ziehen Sie aus der Studie?

Aus meiner Sicht wissen wir im Moment noch nicht genug über neuronale Netze, um sie sicher einsetzen zu können. Solche Programme sind für solche sensiblen Aufgaben nicht robust genug, das haben wir an diesem Fallbeispiel gesehen. Zudem sollte sich der Gesetzgeber meiner Meinung nach nicht darauf verlassen, dass Programme, die Konzerne wie Apple oder Facebook als Reaktion auf ein Gesetz entwickeln, schon das Richtige tun. Es besteht zum Beispiel die Gefahr, dass die Konzerne mehr Inhalte sperren als nötig, sozusagen prophylaktisch, bevor sie in Bedrängnis kommen und hohe Strafen zahlen sein müssen. So ähnlich passiert es ja jetzt schon als Reaktion auf das Netzwerkdurchsuchungsgesetz.

Sollte also besser darauf verzichtet werden, das Hochladen indizierter Bilder automatisch zu verhindern?

Ganz im Gegenteil, meine Kollegen und ich sind dafür, Kinderpornographie auch mit technischen Mitteln zu bekämpfen. Aber wir halten es für wichtig, dass ein gesellschaftlicher Austausch dazu stattfindet, was Bilderkennung mit neuronalen Netzen kann, was sie nicht kann und was wir bereit sind, als Kollateralschaden zu akzeptieren. Es ist aus unserer Sicht immer eine Abwägungssache: Wenn es so leicht ist, ein Programm auszutricksen, ist es dann wirklich vertretbar, es bei allen Leuten zu installieren? Es besteht schließlich die Gefahr, dass es falsch positive Alarme gibt. Und gleichzeitig kann jeder, der das möchte, das System relativ leicht umgehen. Macht es da nicht mehr Schaden, als es nützt? Das ist natürlich nicht die Entscheidung von uns Informatikern. Unser Beitrag besteht darin, die Probleme der Technologie aufzuzeigen, damit auf dieser Grundlage eine sinnvolle Diskussion stattfinden kann.

Interview: Ute Kehse